TensorRT量化实战经验

简介

在前面三个TensorRT量化实战课YOLOv7量化的文章中,都是摘抄自CSND。感谢这个网友的无私风险和总结。这里给出CSDN的链接:https://blog.csdn.net/qq_40672115/article/details/134108526

但是这个只是一个基础的操作。只做这部分只是将模型中通用的Conv层进行量化,但是其他的层没有做其他的操作,这样会做出来的量化精度可能可以,但是模型速度一般比较慢。查看原因可以发现量化后的QDQ模型可能存在大量的reformat节点。这里就是总结一些加速QDQ的量化经验。

常见的onnx op QDQ经验

下面的经验基本上都是解决插入QDQ后速度没有明显提升的问题u。

SVG中的reformat

在SVG图中搜索QDQ,就可以的到所有的因为QDQ引入的reformat节点

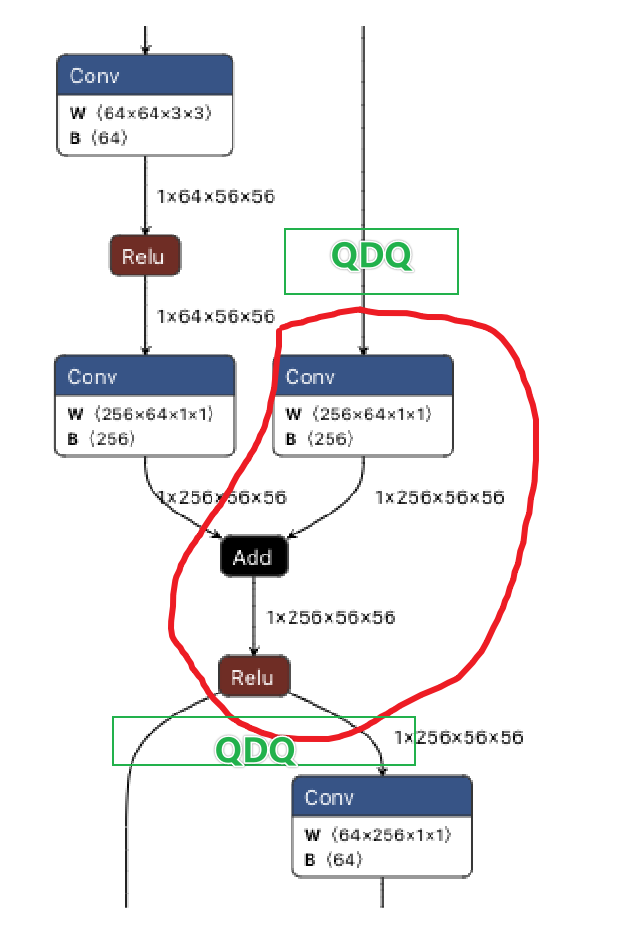

标准残差

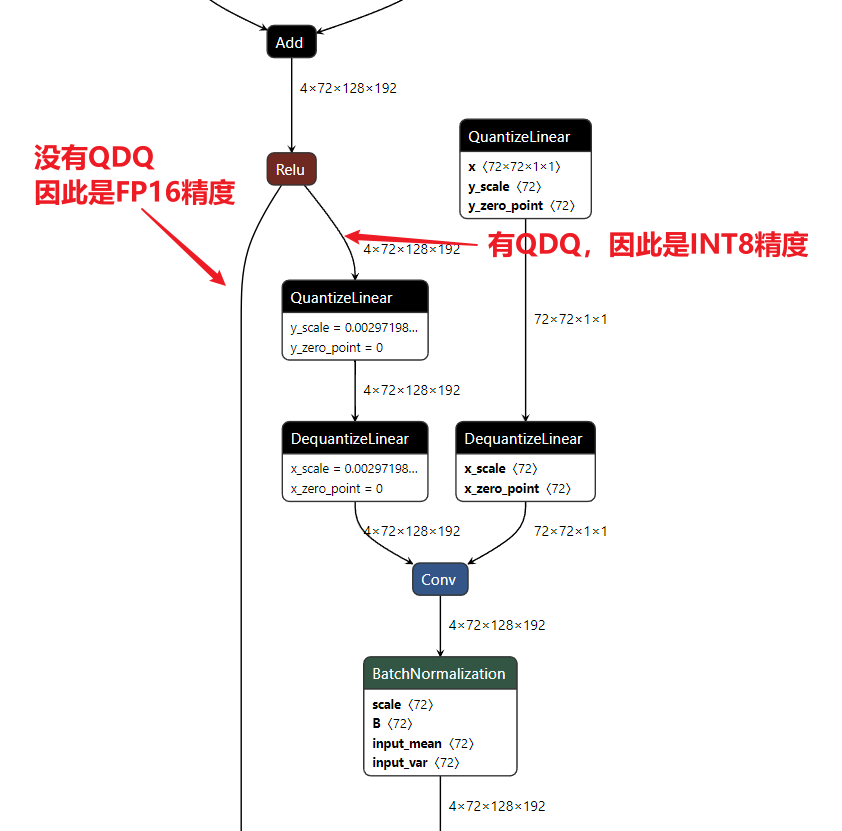

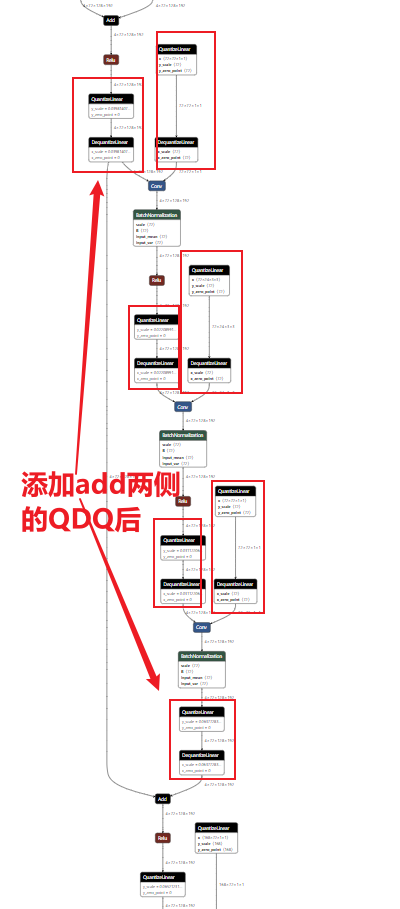

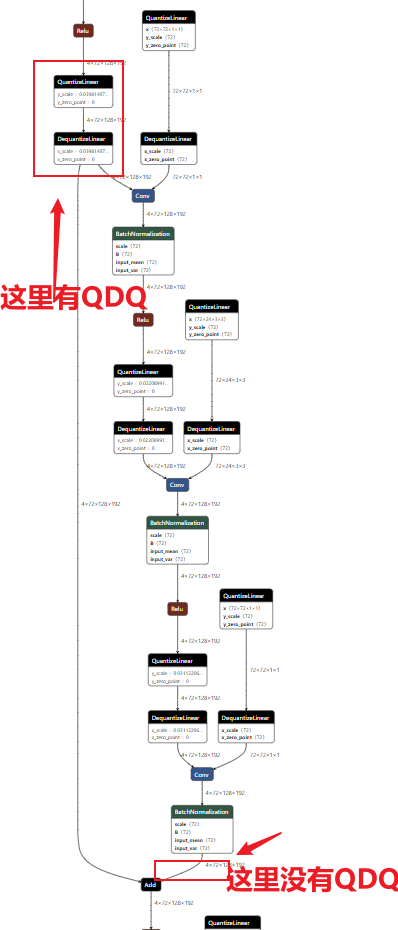

标准的残差结构如下,我们在插入量化节点时,需要在

QDQ1 + Conv + Residual Add + QDQ2, in this case QDQ1 and QDQ2 do not need to match scale values.

在下图的绿色框位置插入QDQ就可以保障红框中的conv add relu 融合。另外这两个QDQ的scale 可以是不同的。

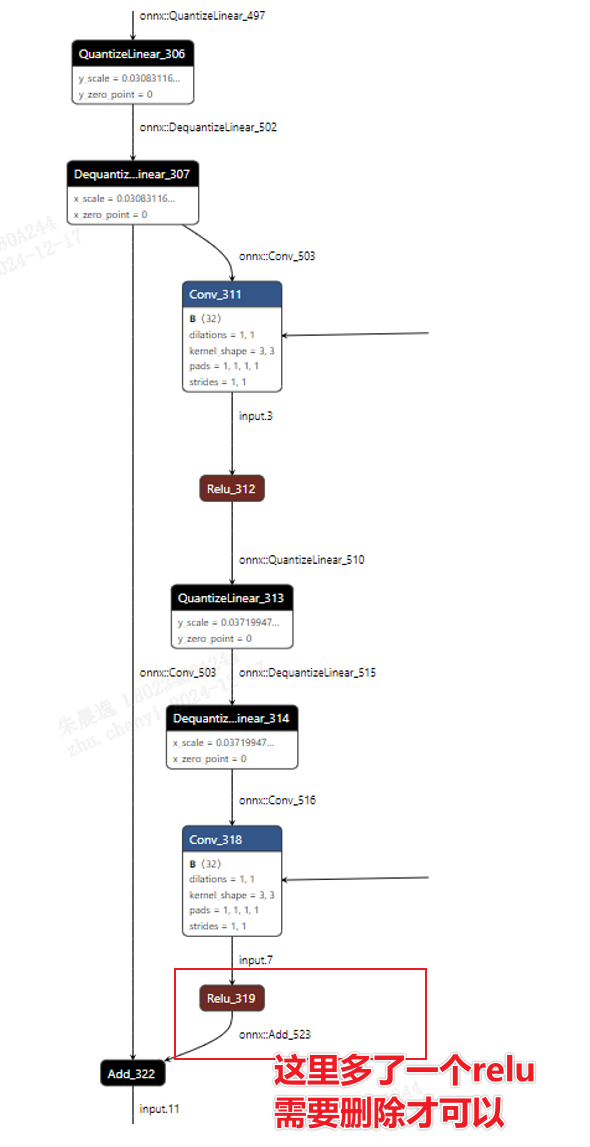

但是,下图不是一个标准的残差,无法融合conv add

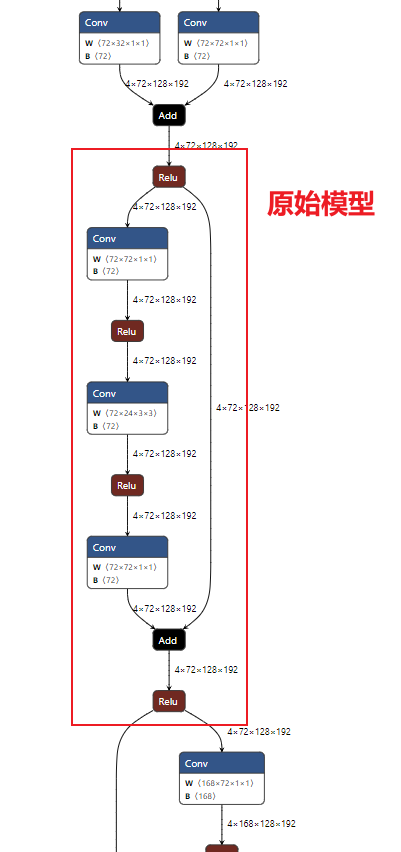

类似ResNet的残差add

- 原始onnx模型结构

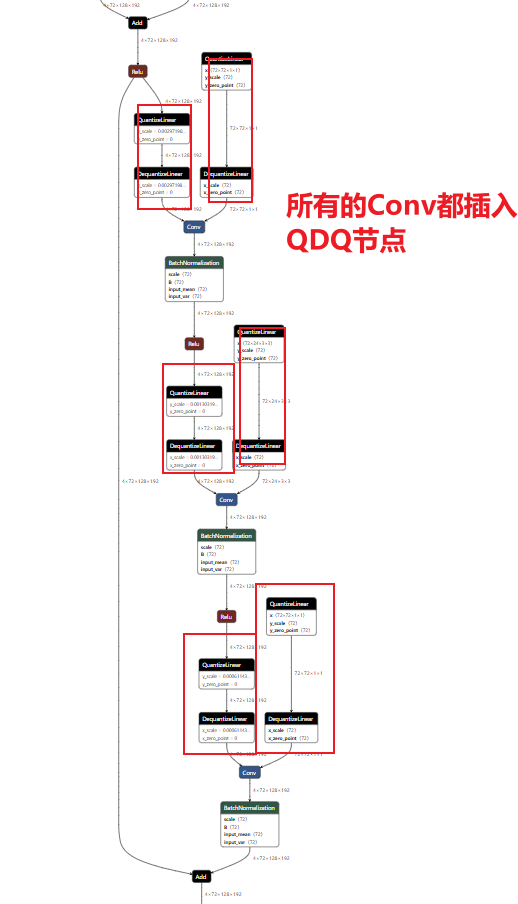

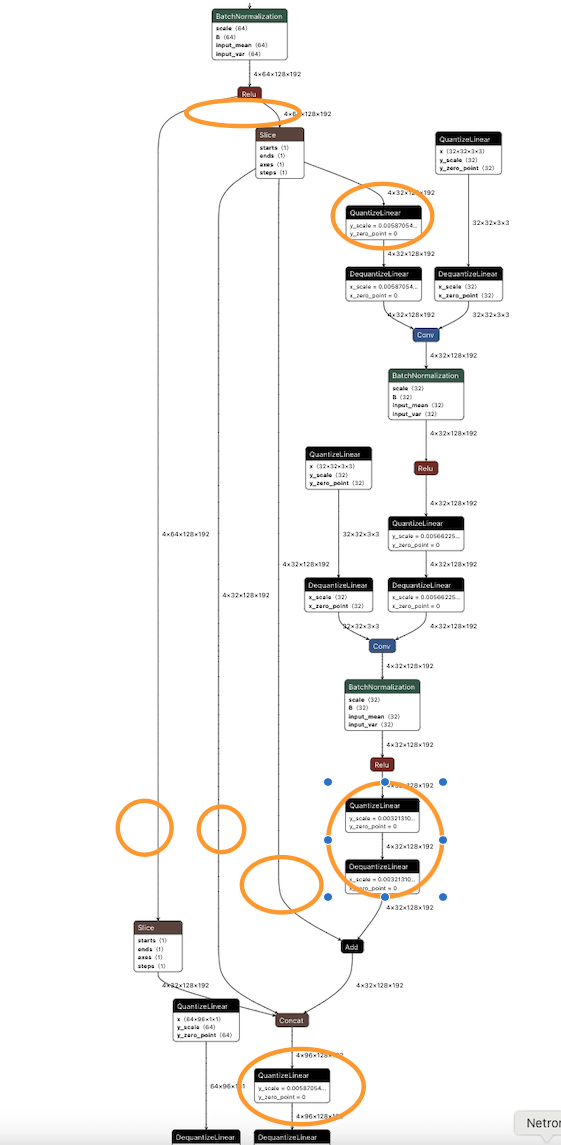

- 所有的Conv插入QDQ

首先,按照“TensorRT量化实战课YOLOv7量化”的方法会将所有Conv层插入QDQ节点如下图

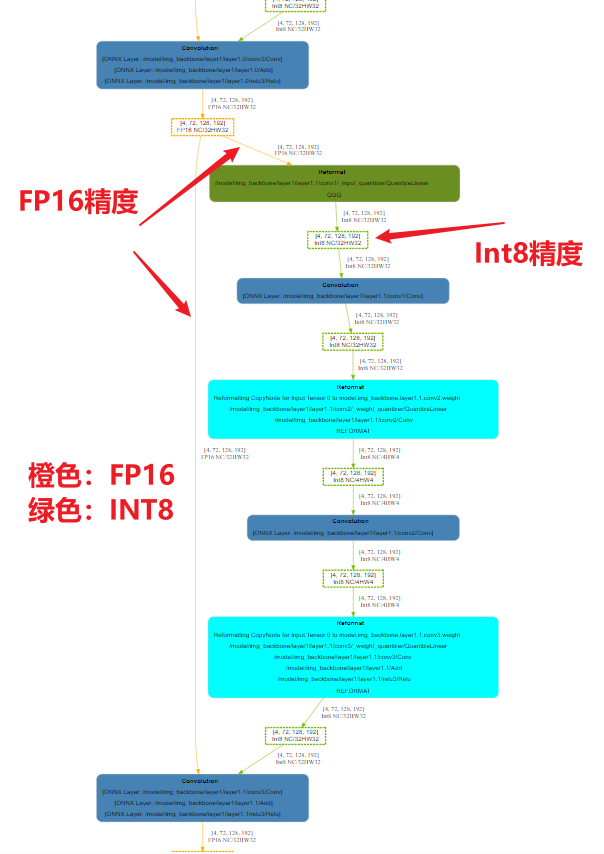

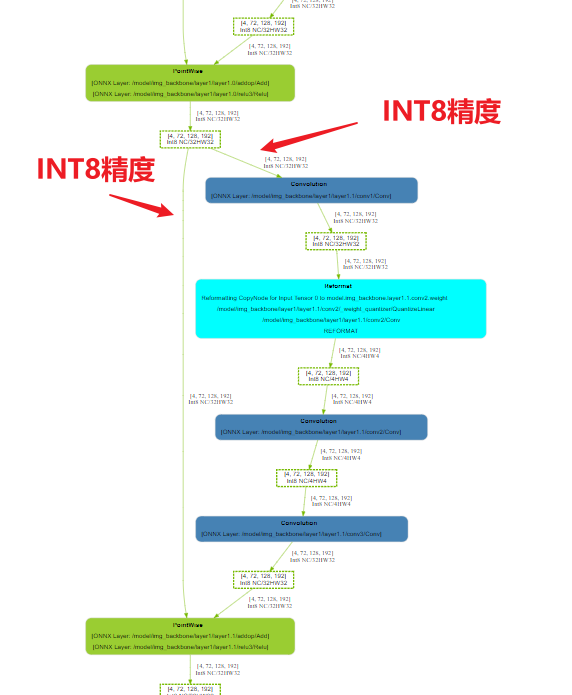

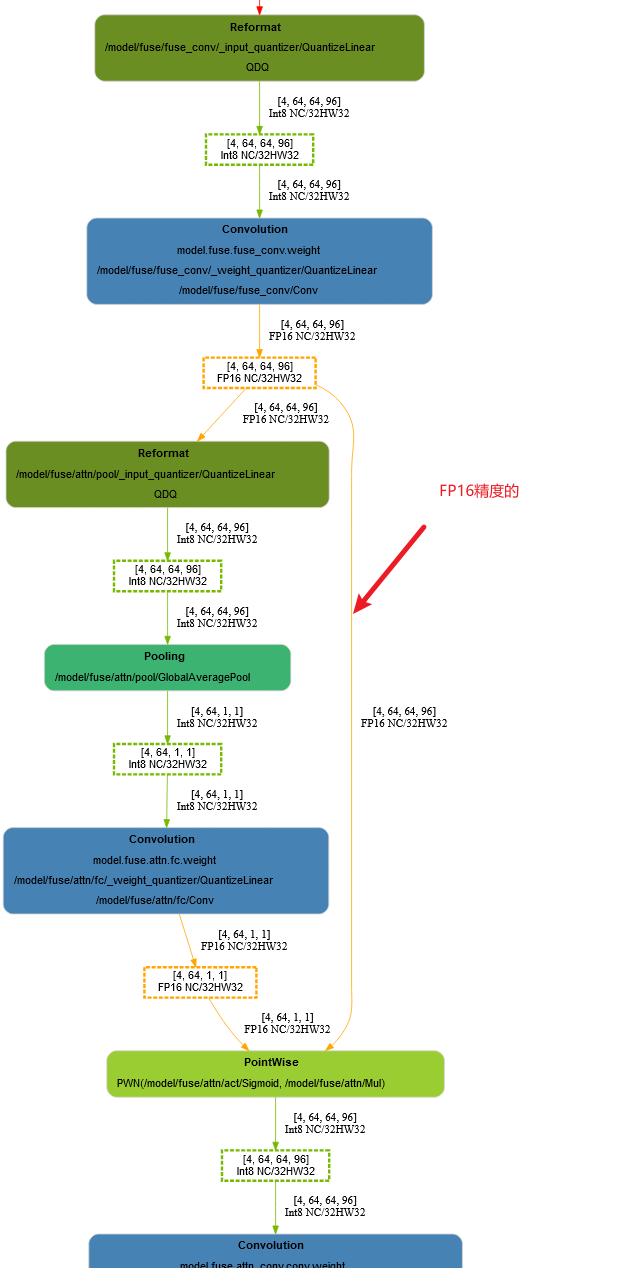

绘制对应的engine结构图图如下:会发现存在一些FP16的精度,是在残差的链接部分。

放大看一下细节

为什么会出现残差是FP16的精度?但是另一侧都是INT8的精度?重新看一下我们插入QDQ后的onnx结构图。

如何解决这个问题呢?修改Add节点的forward函数,将add的两条线中都插入QDQ节点。具体的方法可以参考NV官方代码 https://github.com/NVIDIA-AI-IOT/yolo_deepstream/blob/main/yolov7_qat/quantization/quantize.py

官方代码只是一个修改yolov7的add节点的方法,我们这里需要根据自己的模型结构修改,但是大体都是一样的,就是修改原始的模型的add的forward函数,修改为带有QDQ的add的forward函数。这里就是找出原始模型中add的forward,复制出来修改为QDQ版本,除了Add节点,其他的节点修改都是类似的操作。

这里就有两个问题,

我们如何定位原始的add的forward函数源码?

如果模型不是我们设计的,那我们可以debug来定位。

我们如何修改原始add为量化后的add节点?

这里就需要编写代码找到模型中的所有需要修改的add节点,如下面的代码就是通过下面的代码段找到Bottleneck中的所有add节点。如果不知道Bottleneck这个名字,我们依然可以使用debug来一步一步查看模型结构及名称,找到自己需要修改的模型部分的名称。

1

2for name, bottleneck in model.named_modules():

if bottleneck.__class__.__name__ == "Bottleneck":

1 | class QuantAdd(torch.nn.Module): |

例如我在另一个模型的结构中就是如下代码,实际是类似的,mmdet.models.backbones.resnext.Bottleneck是我debug找到的名字。

1 | def replace_bottleneck_forward(module, quantization): |

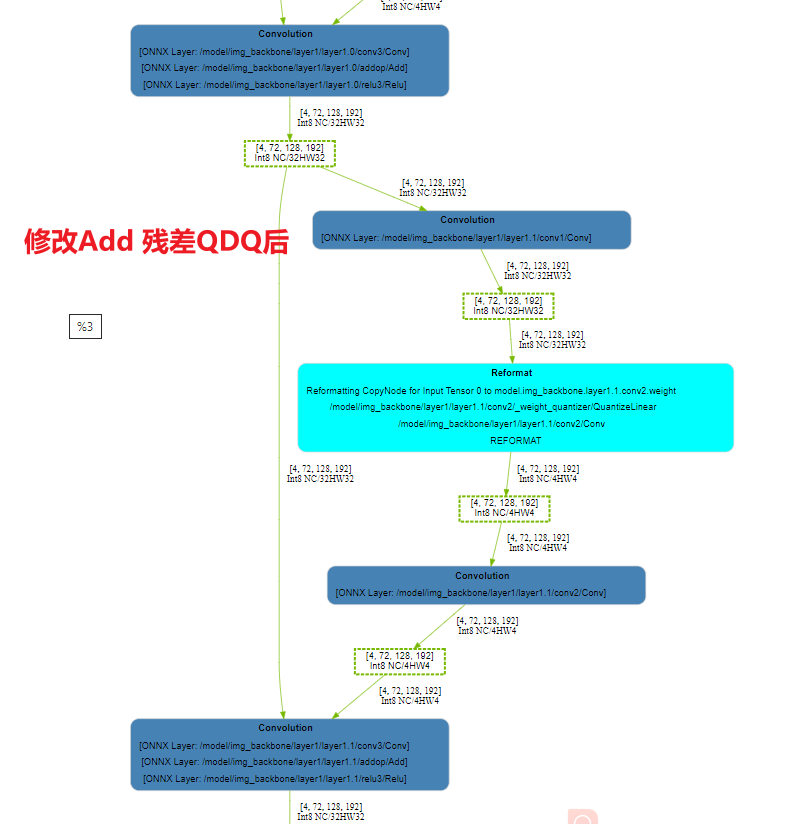

根据上述方法,修改我们的模型的add节点为带有QDQ的add,重新生成onnx文件并绘制engine结构图如下:

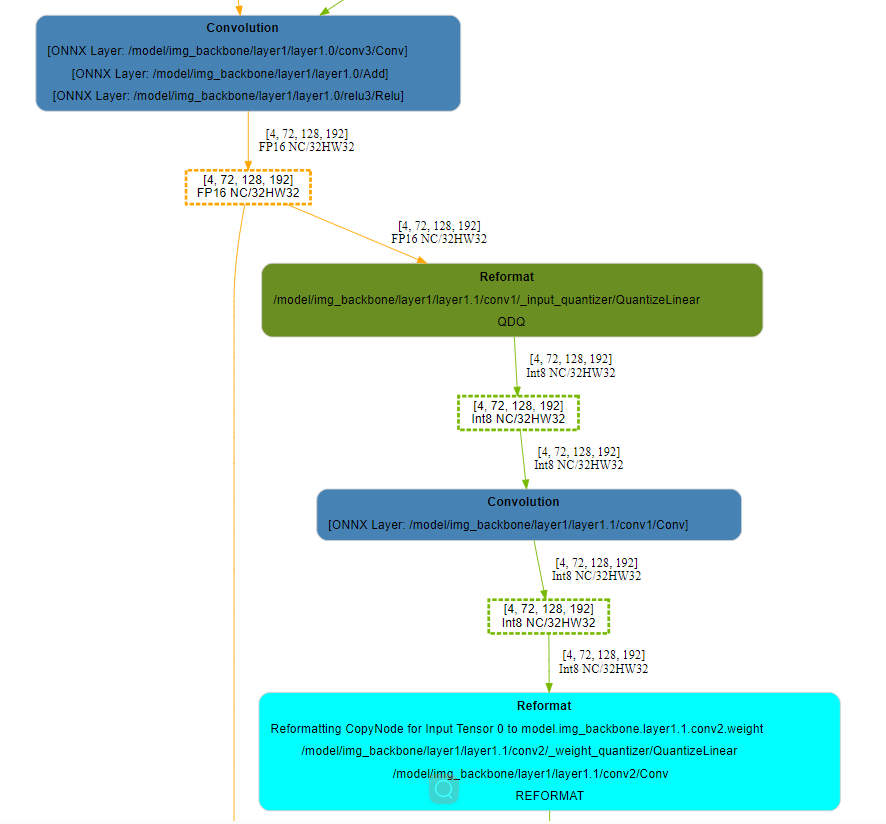

从下onnx可以看到我们的add两个分支都有了QDQ节点。

绘制对应的engine图如下,可以看出add两个分支都是INT8精度了。

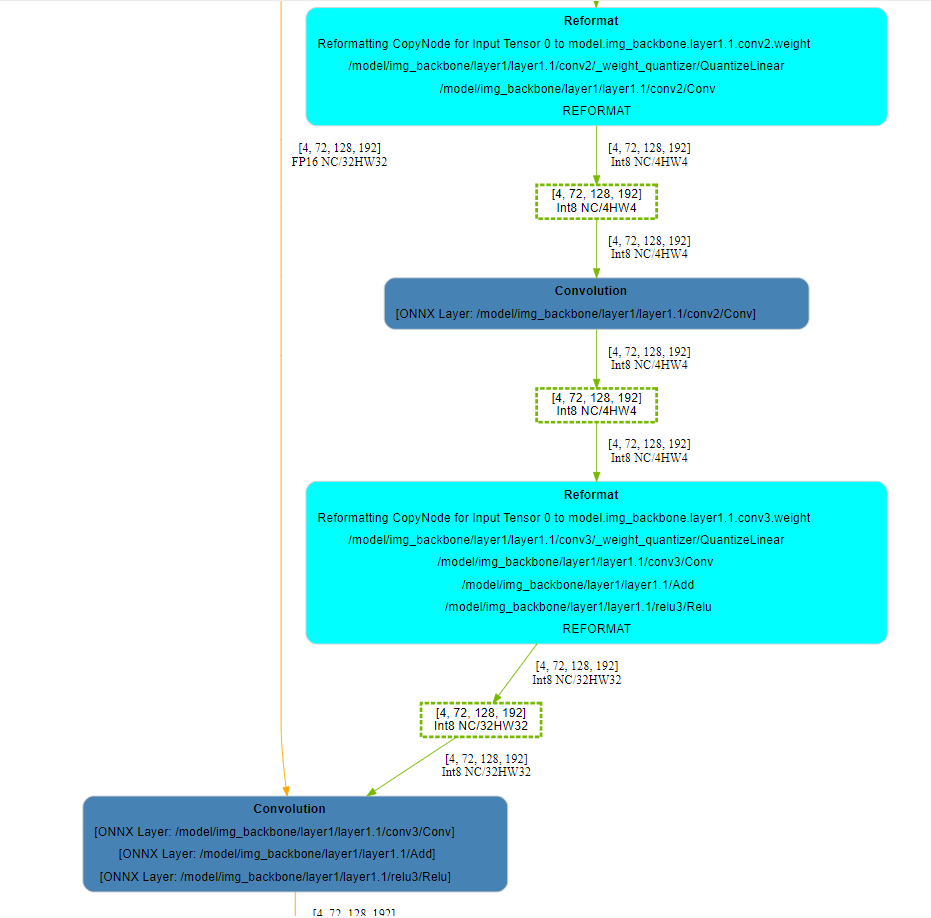

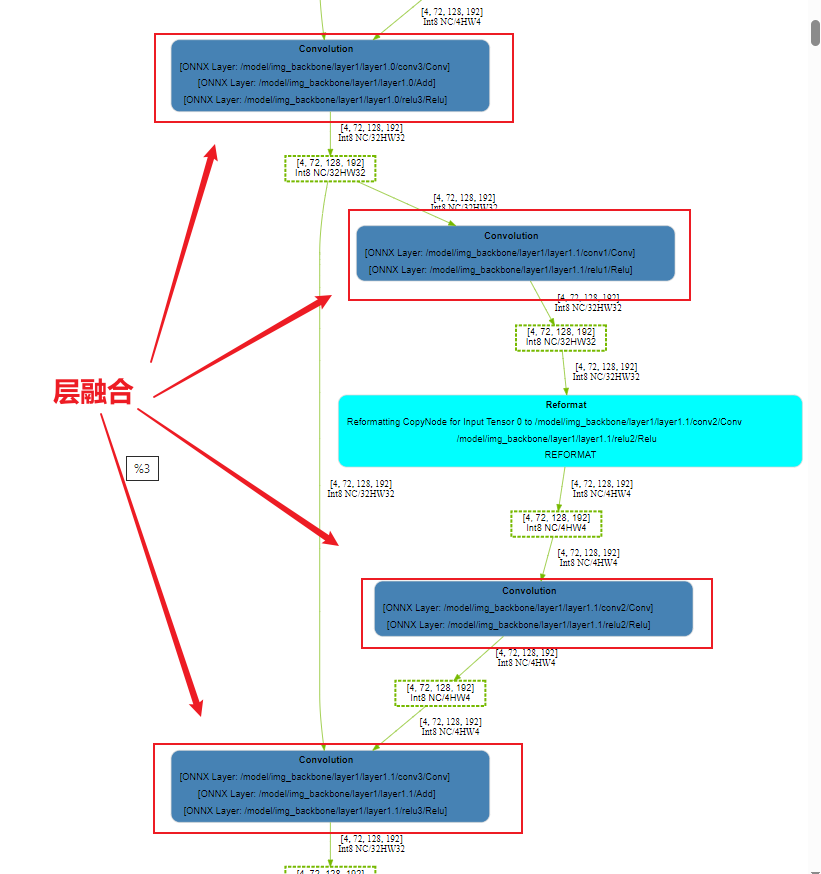

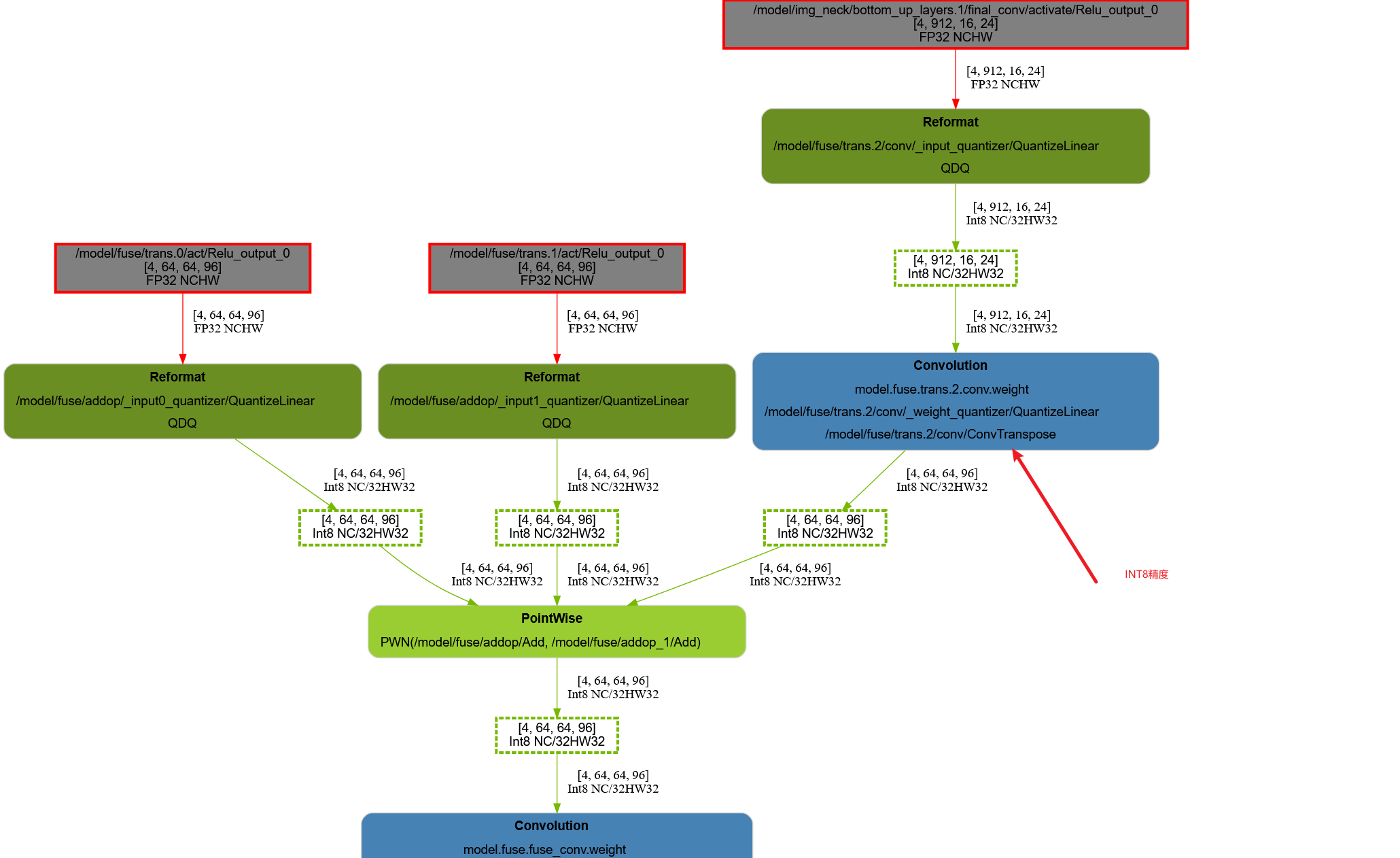

但是到这里还没有完。。。我们对比一下使用trtexec —best参数转换的engine。如下图

可以看到—best参数转换的engine的层融合和上图不同,上面的图最后一层是PointWise,只融合了add和relu,但是—best融合了conv、add、relu。

1 | PointWise |

那么如何做到类似—best一样的层融合呢?

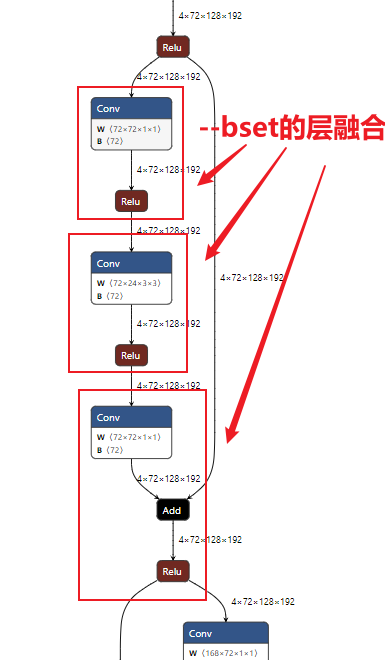

观察一下—best的融合层,在onnx中是如下图。

结合前面博客提到的 7-TensorRT中的INT8 | 奔跑的IC 7.4.4. Q/DQ Layer-Placement Recommendations,官方文档5.3.5.2. Q/DQ Layer-Placement Recommendations 都有提到融合的策略。

那我需要针对惨差的Add节点修改一下,不能共用官方代码yolov7的QuantAdd了。修改方法如下:

- 残差的Add两个分支,只有残差的分支添加QDQ,另一个分支不添加QDQ。

修改后的代码如下

1 | class QuantAdd(torch.nn.Module): |

修改后的onnx如下

对应的engine图如下:可以看出已经和 —best的一致了。至此已经算是优化完成了。

(可以看到—best和我们下面的图是一致的,但是都有一个Reformat节点,这个节点大大影响了我们的速度,这个reformat节点本来是不应该存在的,但是因为为了利用Tensor core,Tensor对int8 的对齐要求是32 ,参考Part5-3-TensorRT性能优化性能优化技巧 | 奔跑的IC 从trt的日志也可以看出

1 | Layer(Reformat): Reformatting CopyNode for Input Tensor 0 to /model/img_backbone/layer1/layer1.1/conv2/Conv + /model/img_backbone/layer1/layer1.1/relu2/Relu, Tactic: 0x0000000000000000, /model/img_backbone/layer1/layer1.1/relu1/Relu_output_0 (Int8[4,72:32,128,192]) -> Reformatted Input Tensor 0 to /model/img_backbone/layer1/layer1.1/conv2/Conv + /model/img_backbone/layer1/layer1.1/relu2/Relu (Int8[4,72:4,128,192]) |

这里就是提示就是72不是32整除的,因此有一个reformat节点,为了充分的利用tensor core(对conv来说 32字节对齐的是C,也就是NCHW中的C需要是32字节对齐)。这个问题可以通过修改网路结构来消除。

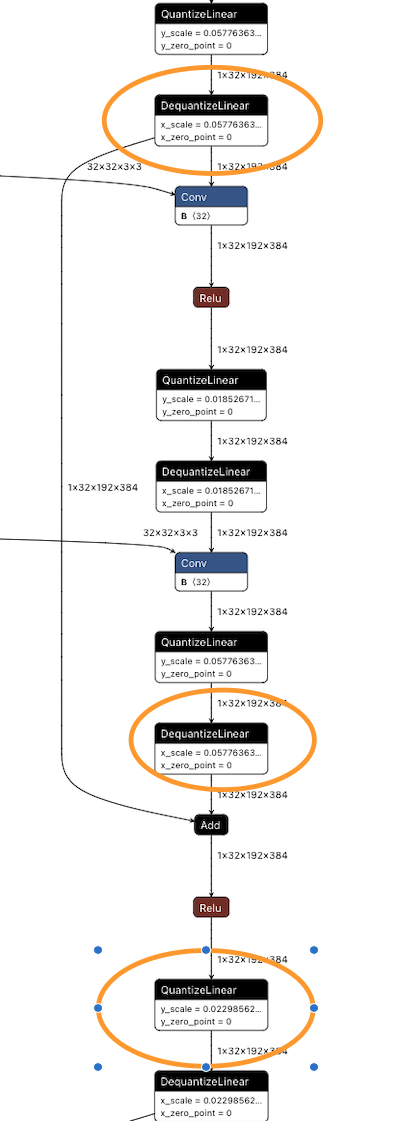

另一种情况

t if you insert the QDQ in this way, confirm the there QDQ has the same scale otherwise there will be additional reformat here.

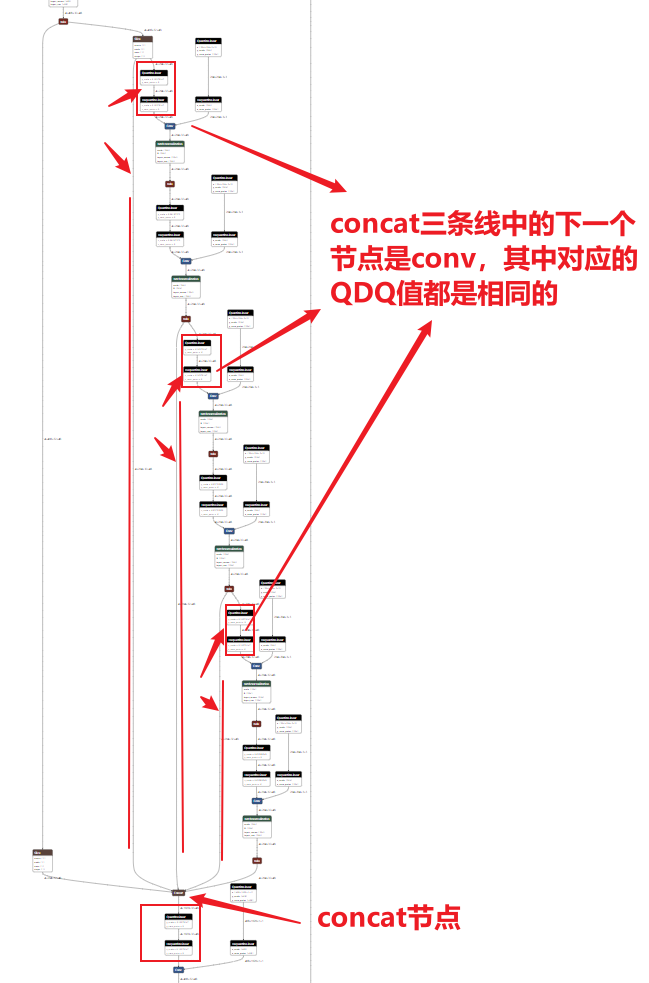

concat节点

concat穿透:结合之前的“带有QDQ的onnx用trtexec转engine日日志分析”可以看出concat后面的Q会被穿透到concat上面。

在官方代码中有一个函数是apply_custom_rules_to_quantizer

1 | def apply_custom_rules_to_quantizer(model : torch.nn.Module, export_onnx : Callable): |

其中的函数find_quantizer_pairs定义如下:

1 | def find_quantizer_pairs(onnx_file): |

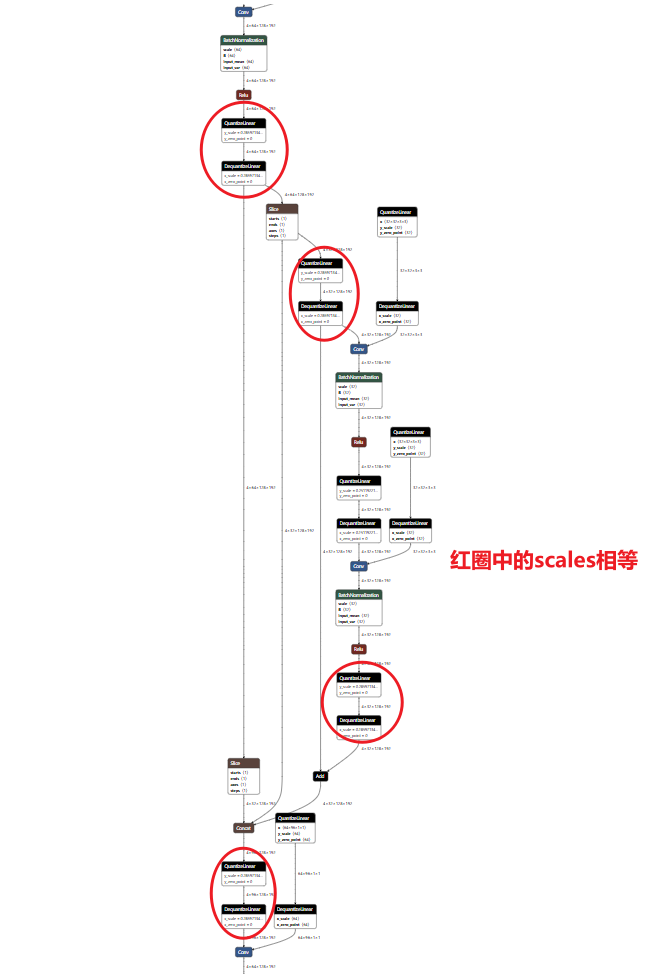

这段find_quantizer_pairs代码就是找到一些匹配对,然后使用下面的函数让这些匹配对的QDQ是相同的,也就是scales是相同的。因为一个concat节点只是连接数据,并没有计算,所以concat连接的几个节点scales应该是相同的。可以加速。

1 | for major, sub in pairs: |

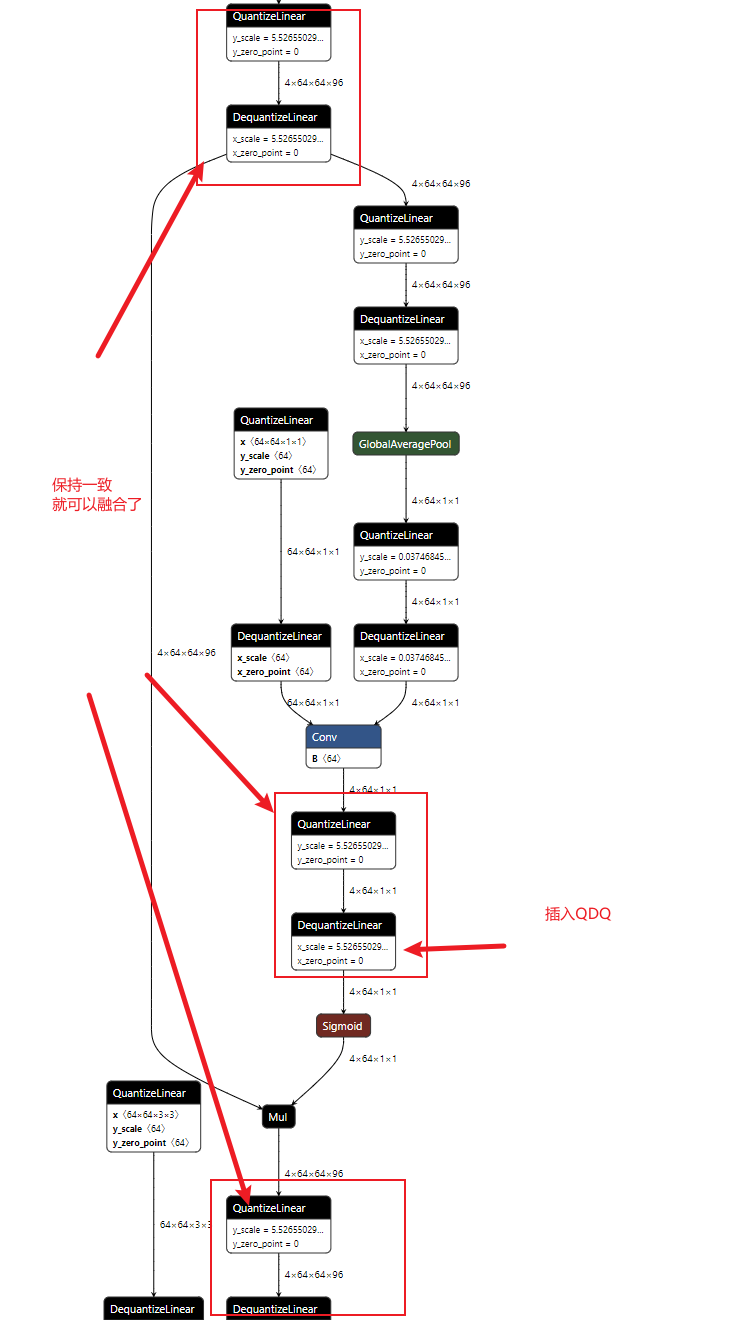

对应如下图可以好理解一些。

上面的图太不清晰了,画一个示意图解释一下

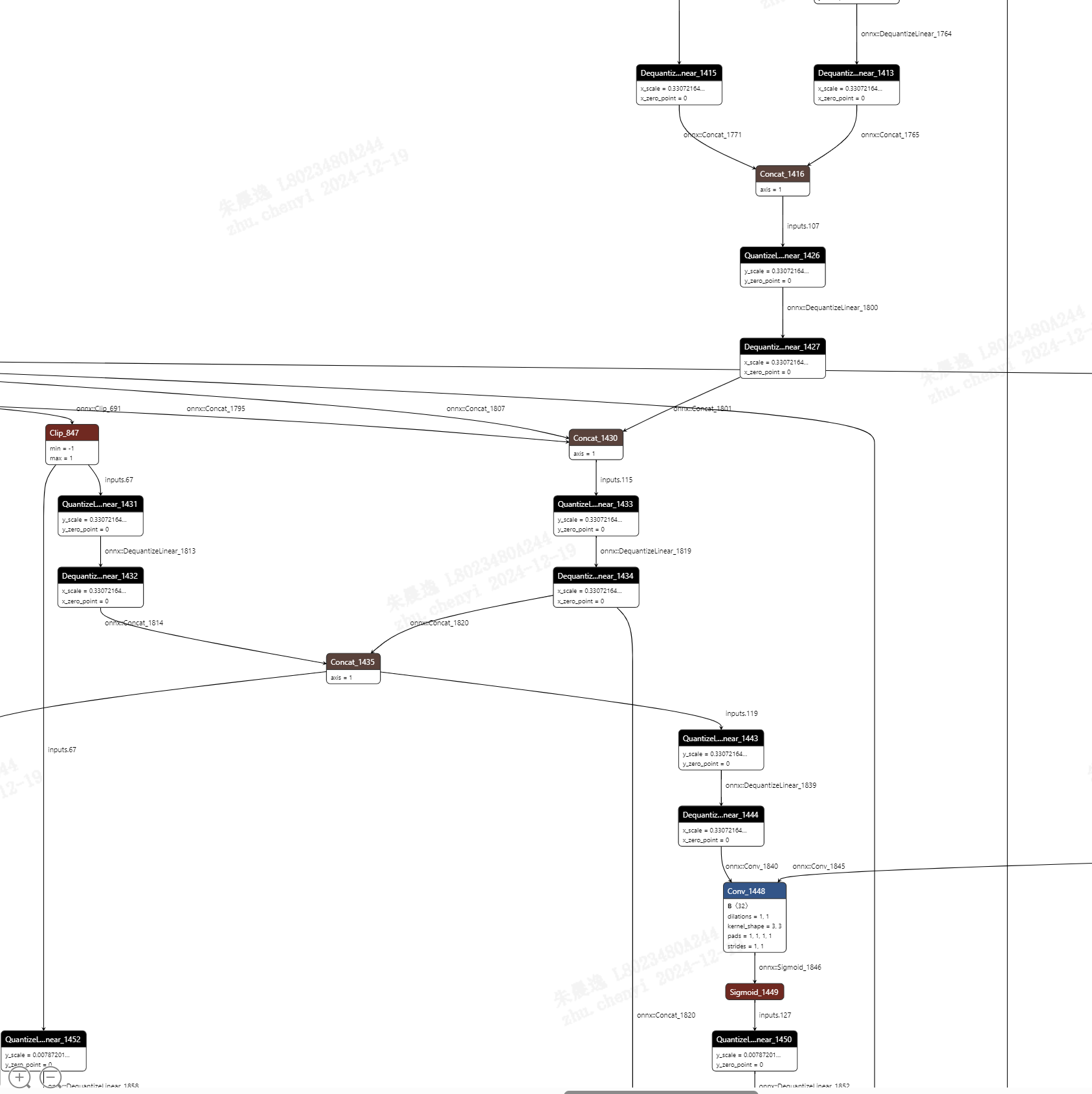

下面是另外一个concat节点的例子:

[Concat_1435] concat with [Concat_1430] and [Concat_1416]. that would all be one tensor inside TensorRT is internal represitation.

Make all The QDQ related with [Concat_1435]& [Concat_1430]&[Concat_1416] the same scale would elimite all the reformats here.

MUL节点

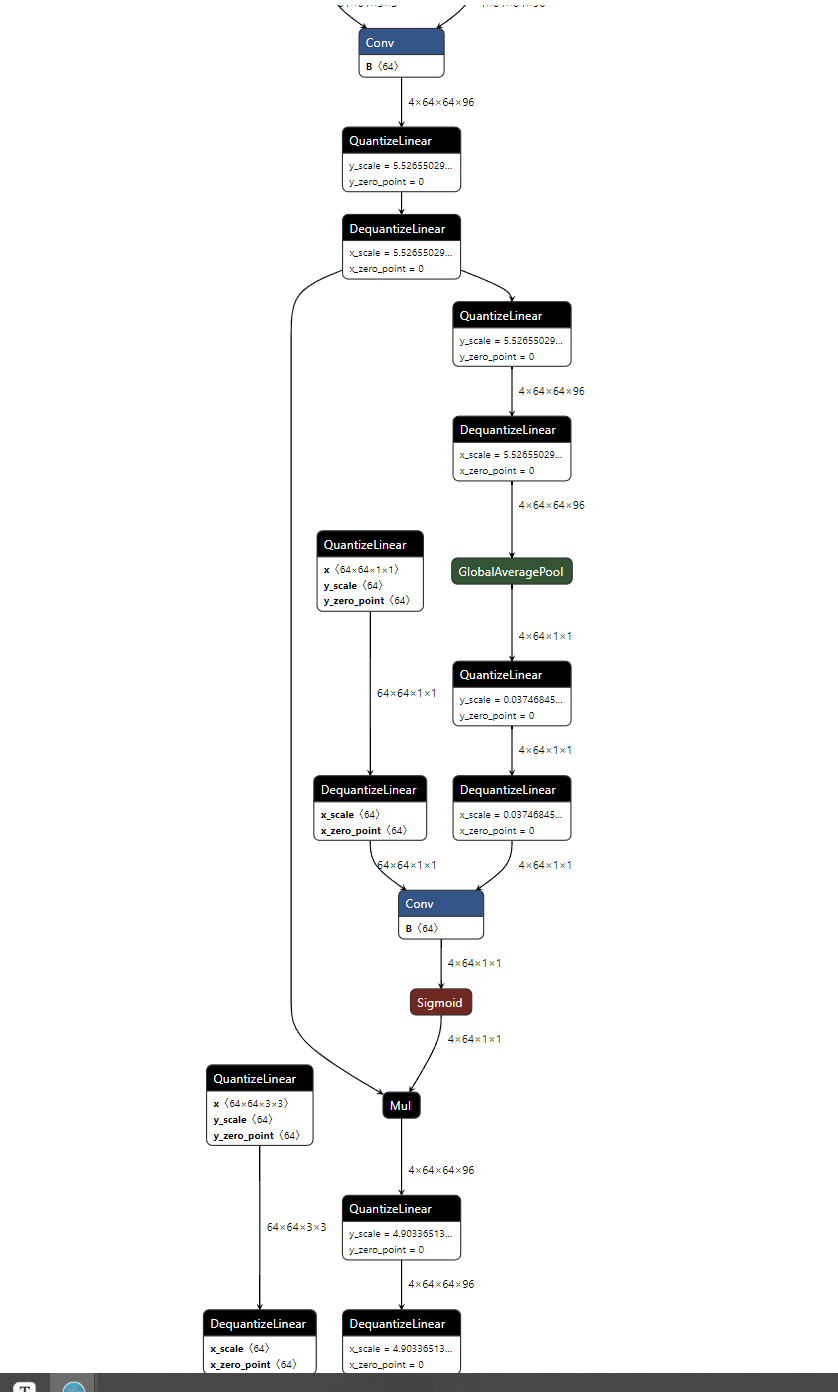

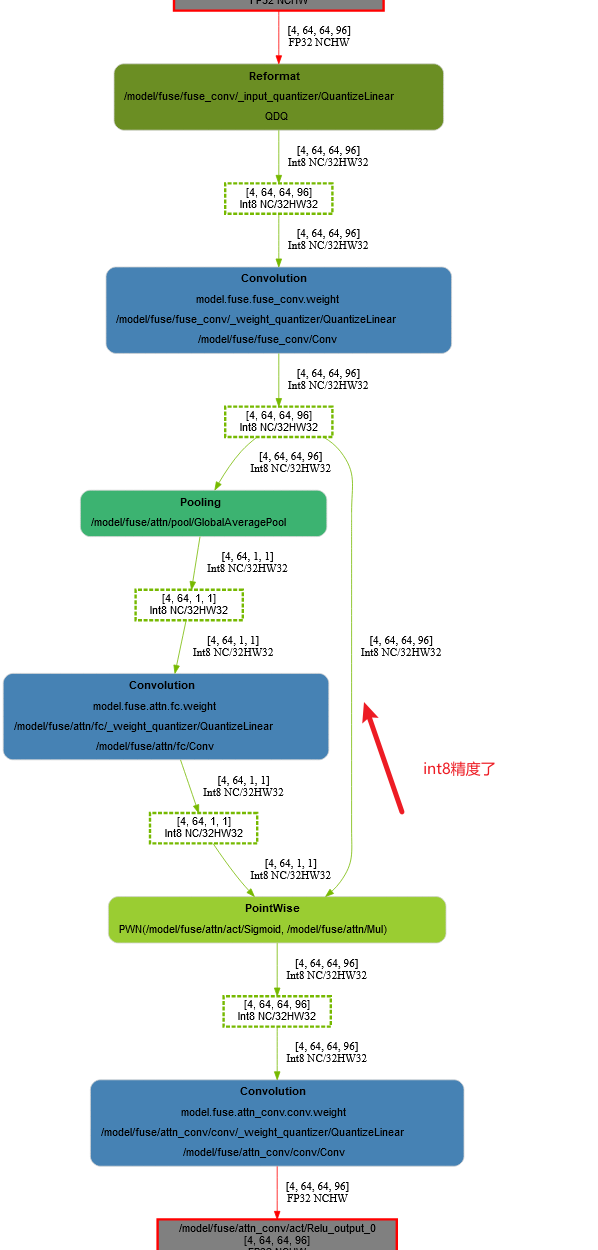

首先看一下第一种没有INT8的情况

对应的onnx如下,看上去插入的QDQ都是正确的。

但是绘制对应的engine结构图如下:

如何修改呢?针对上面的情况,在sigmoid前面插入一个QDQ,同时保证下图三个QDQ的值是相同的即可

修改后的如下图onnx

修改后的engine结构图如下:

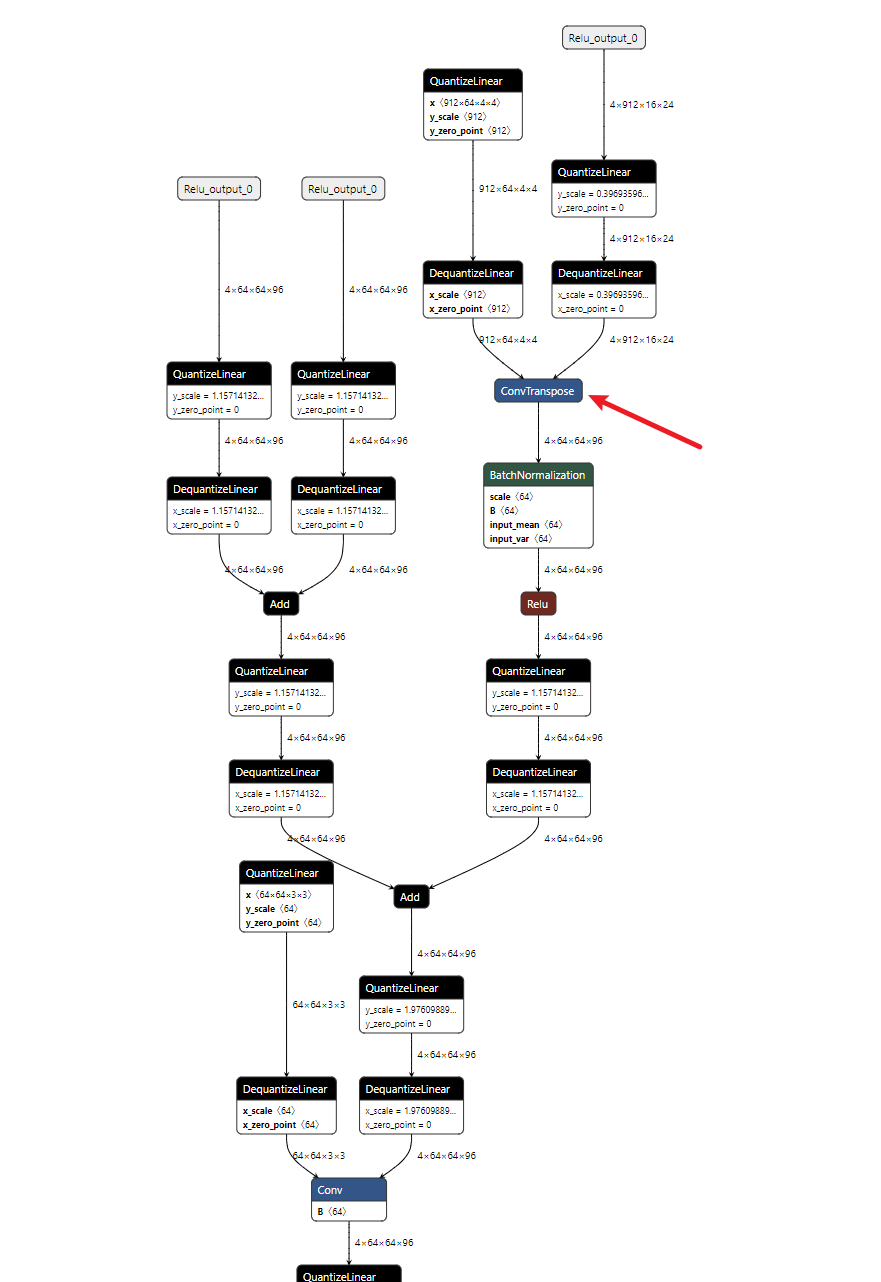

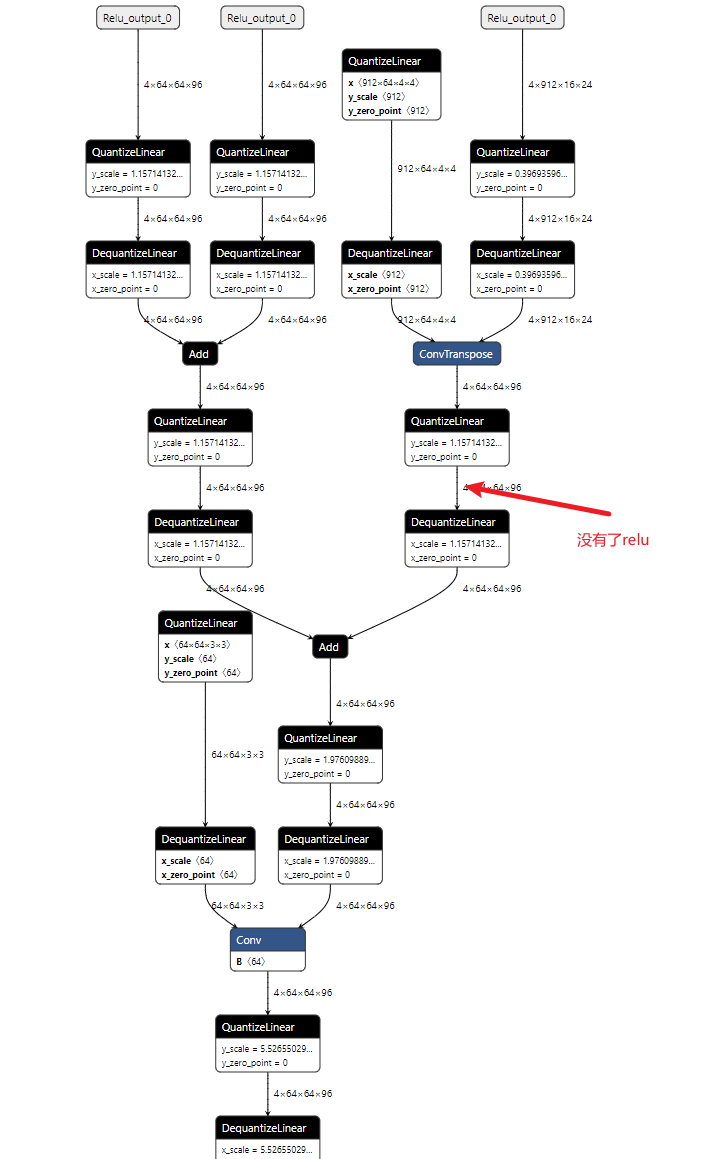

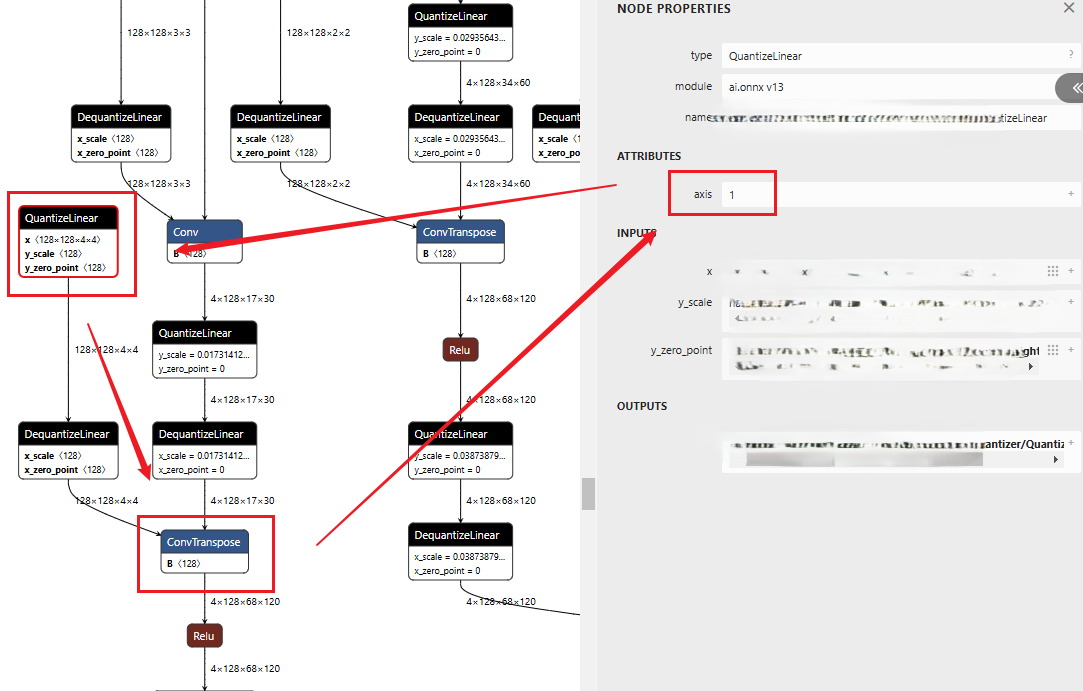

convTranspose节点

首先看一下我们初步插入QDQ后的onnx结构图,看样子应该没有问题

对应的engine图如下

发现在relu前竟然转换为了FP32精度

如何修改呢?修改方式是删除relu层,修改后的onnx如下:

修改后的engine图对应如下:

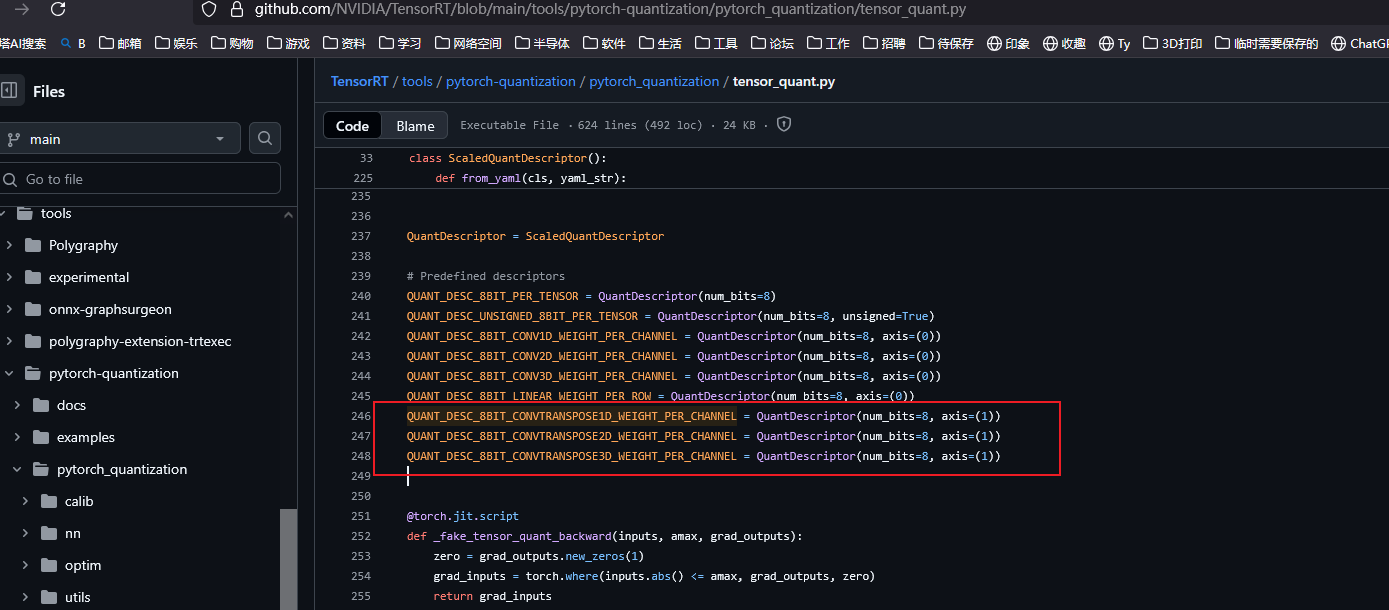

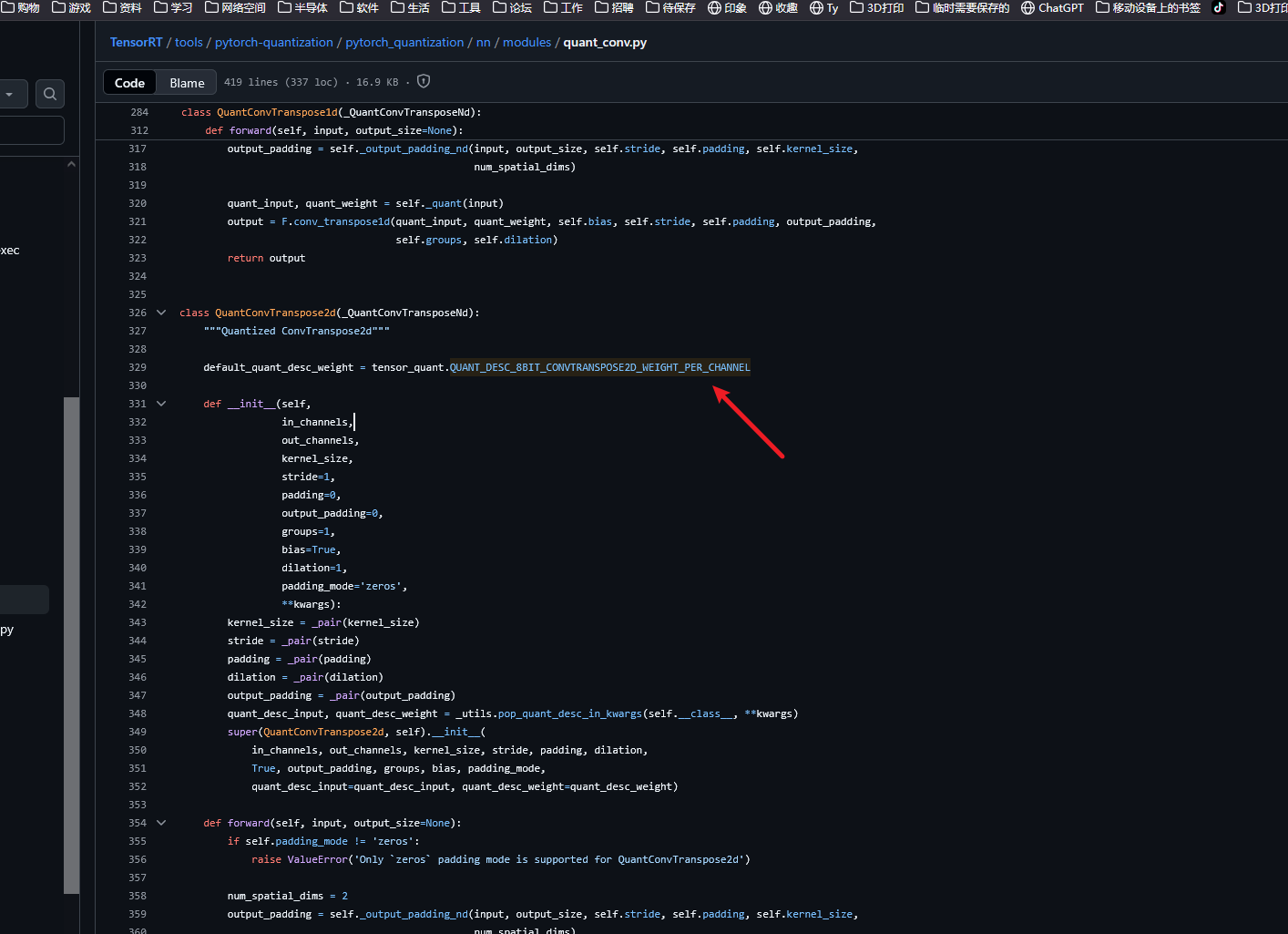

convTranspose的量化bug1

在convTranpose 时,scale 的维度默认设置在 axis=0。实际上这是不正确的。TRT9.2以前对convTranspose的scale计算会存在问题。可以在initialie函数时单独设置一下。这个bug在后面的tensorRT中已经修复了。可以查看

自己代码参考 https://zmurder.github.io/TensorRT/NV%E9%87%8F%E5%8C%96%E4%BB%A3%E7%A0%81%E5%88%86%E6%9E%90/?highlight=def+initialize%28%29

1 | def initialize(): |

官方的修复如下(截至日期2025.09.08)

正确的如下

ConvTranspose 量化bug2

TRT-8.6有一个已知的问题,在QDQ模式下ConvTranspose不能与BN融合

正确的如下图

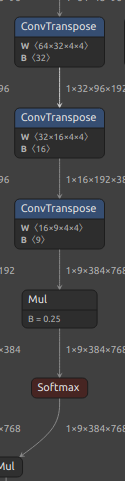

INT8的速度比INT16还要慢

有的时候量化为INT8不一定比INT16更快,例如下面的ConvTranspose

由于这三个 ConvTranspose 层的输入通道较小 (≤32),预计 FP16 策略将比 INT8 策略更快。因此,您无需为这些层插入 QDQ 节点。 低精度不适用于输入通道太小的 Convs/Deconvs

一些特殊的例子

Slice 和 Concat 的行为规则相似。TensorRT 会在内部消除 concat/slice 节点(这就是为什么在 SVG 中找不到 concat/slice 节点的原因)。

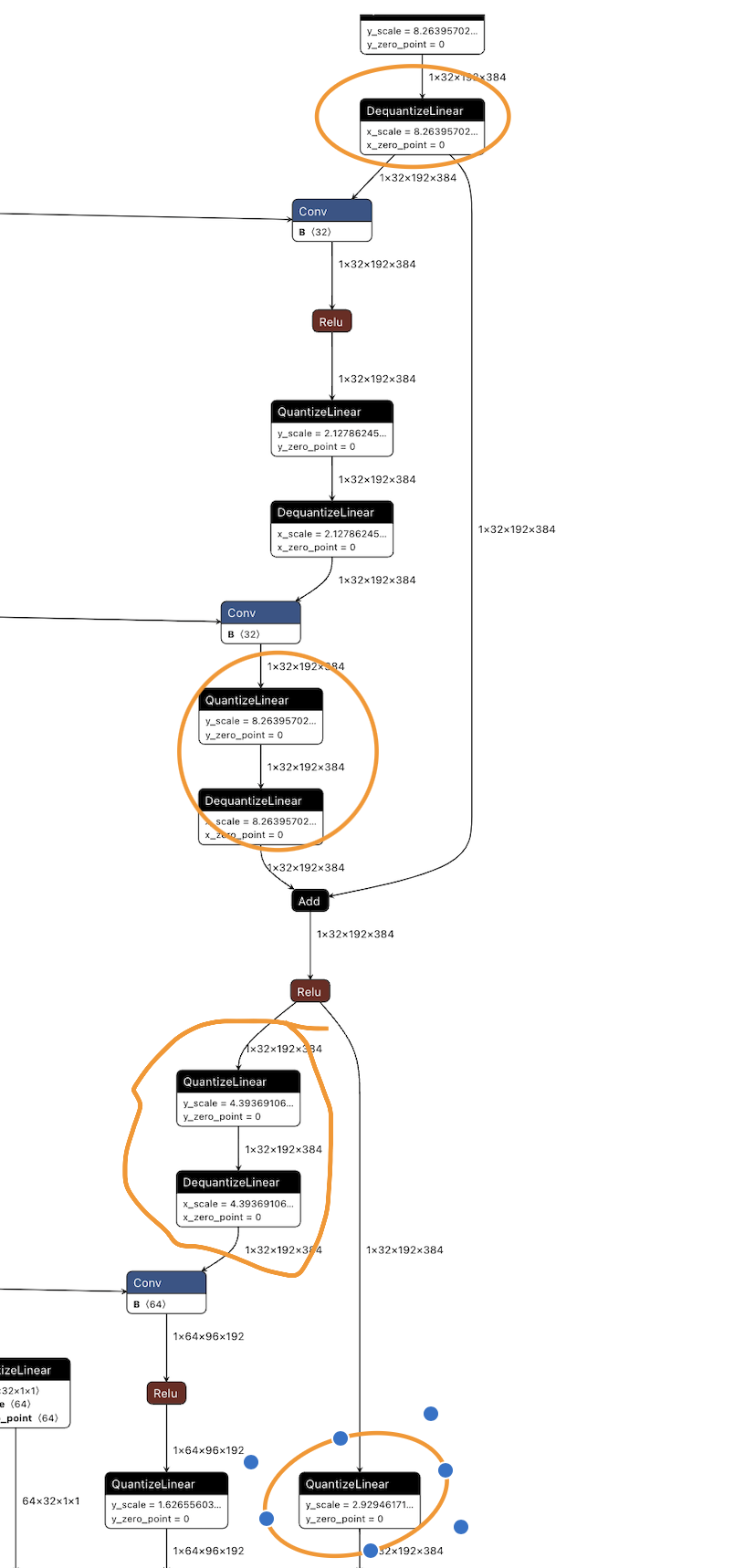

因此,在 TensorRT 内部,concat/slice 的输入和输出将合并为一个张量。用户必须确保与同一个 concat/slice 相关的量化和去量化(QDQ)操作保持一致。

对于 PWN(Pointwise)节点,用户必须确保输入和输出具有相同的缩放比例(scale)(对于ReLU、Add等PointWise操作,输入和输出的scale无需强制对齐。心思路是验证插入的Q/DQ节点能否与相邻的卷积(Conv)+ 激活(Act)操作完全融合。若单个融合后的卷积节点存在多个具有不同量化尺度的Q/DQ节点,则无法合并,这会导致额外的重新量化操作(Reformatting QDQ)和无意义的延迟开销。)。您可以在 SVG 中检查哪些节点被归类为 PWN 节点,有时它可能是一个单独的 Add 操作,有时则是 Add+Mul 组合。

根据上面的原因,确实应该下图橙色框适当的位置插入 QDQ(量化和去量化)节点,并确保它们都使用相同的缩放比例。这样做可以保证模型转换后的精度,并且确保 TensorRT 在优化过程中能够正确处理这些操作。

按照上面的修改后的engine如下

PWN算子

PWN(与 Add + Relu 融合)的 In out scale应该相同,也就是说,以下 4 个 QDQ 应该具有相同的 scale。 (图示是错误的例子,应该是相等的才可以,注意add的输入和输出都应该是相等的,in out scale)

conv共享权重

Please copy the weight for the convs who share the weight with another conv.否则会转换engine失败

engine结构图的绘制

上面都提到了engine结构图的绘制,之前的博客也提到了enigne结构图如何绘制,这里再重新说明一下

在使用trtexec转换onne为engine时添加参数

--exportLayerInfo=layer.json --profilingVerbosity=detailed --exportProfile=profile.json例如:

1

$ /usr/src/tensorrt/bin/trtexec --onnx=yolov7.onnx --fp16 --int8 --verbose --saveEngine=yolov7_ptq.engine --workspace=1024000 --warmUp=500 --duration=10 --useCudaGraph --useSpinWait --noDataTransfers --exportLayerInfo=yolov7_ptq_layer.json --profilingVerbosity=detailed --exportProfile=yolov7_ptq_profile.json

we use TensorRT opensource tool: trt-engine-explorer drawing the enqueue graph of TensorRT. This tool take the trtexec exported layer json information as input. Use the below code to draw the TensorRT-Engine-graph.(edit from

trt-engine-explorer/utils/draw_engine.py)1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31import graphviz

from trex import *

import argparse

import shutil

def draw_engine(engine_json_fname: str, engine_profile_fname: str):

graphviz_is_installed = shutil.which("dot") is not None

if not graphviz_is_installed:

print("graphviz is required but it is not installed.\n")

print("To install on Ubuntu:")

print("sudo apt --yes install graphviz")

exit()

plan = EnginePlan(engine_json_fname, engine_profile_fname)

formatter = layer_type_formatter

display_regions = True

expand_layer_details = False

graph = to_dot(plan, formatter,

display_regions=display_regions,

expand_layer_details=expand_layer_details)

render_dot(graph, engine_json_fname, 'svg')

if __name__ == "__main__":

parser = argparse.ArgumentParser()

parser.add_argument('--layer', help="name of engine JSON file to draw")

parser.add_argument('--profile', help="name of profile JSON file to draw")

args = parser.parse_args()

draw_engine(engine_json_fname=args.layer,engine_profile_fname=args.profile)draw the graph:

1

2$ python draw_engine.py --layer yolov7_qat_layer.json --profile yolov7_qat_profile.json

$ python draw_engine.py --layer yolov7_ptq_layer.json --profile yolov7_ptq_profile.jsonwe get

yolov7_qat_layer.json.svgandyolov7_ptq_layer.json.svg

常量折叠

For the extra op(Cast, Sqrt) after quantization, you can use polygraphy to do constant-fold, then the extra op will be elimicated:

$ polygraphy surgeon sanitize your_model.onnx -o mod_your_model.onnx —fold-constants

QAT训练

初始lr(经验值为1~5%原始训练lr,对于orin multitask可以直接使用5e-6

- - lr_config ,可以删去warm_up的选项(QAT微调时无需warm up),同时减小min_lr,否则学习率变化过小。

lr_config 1

2

3

4

5

6policy='CosineAnnealing',

\# warmup='linear',

by_epoch=False,

\# warmup_iters=100,

\# warmup_ratio=0.1,

min_lr=1e-7)