目标检测基础

发表于

分类于

DeepLearning

,

基础

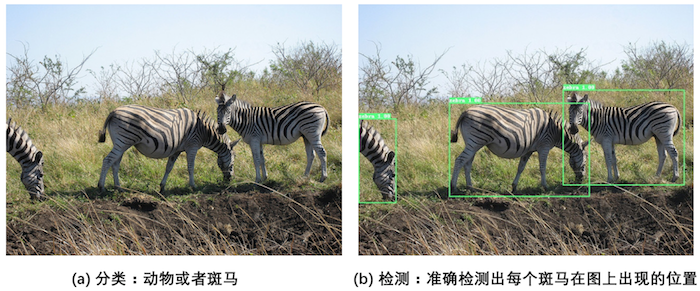

对计算机而言,能够“看到”的是图像被编码之后的数字,但它很难理解高层语义概念,比如图像或者视频帧中出现的目标是人还是物体,更无法定位目标出现在图像中哪个区域。目标检测的主要目的是让计算机可以自动识别图片或者视频帧中所有目标的类别,并在该目标周围绘制边界框,标示出每个目标的位置,如 图1 所示。

目标检测mAP计算

发表于

分类于

DeepLearning

,

基础

双线性插值

发表于

分类于

DeepLearning

,

基础

卷积神经网络基础

发表于

分类于

DeepLearning

,

基础

关于onnx的resize层

发表于

分类于

DeepLearning

,

基础

ROI pooling

发表于

分类于

DeepLearning

,

基础

NCHW和NHWC

发表于

分类于

DeepLearning

,

基础

8 MobileNetv3

发表于

分类于

DeepLearning

,

图像分类网络

7 MobileNet

发表于

分类于

DeepLearning

,

图像分类网络